最近、画像作成AIは大きな進化を遂げていますが、画像処理は遅れています。

画像処理は、最近のAI画像作成技術の進歩に比べて、一歩遅れていました。しかし、それは今までの話です。

なぜなら、アップルが複雑なテキスト命令を理解し、実行する方法を示しているからです。

Appleが共同で開発した新しいオープンソースAIモデル

アップルは、カリフォルニア大学の研究者と協力して、自然言語命令を使用して画像を編集する新しいオープンソースAIモデルを開発しました。それは「MGIE」と呼ばれ、Multimodal Large Language Models Guided Image Editingの略です。

MLLMを使用してテキスト命令を解釈し、画素精度の高い画像操作を実行

MGIEは、Multimodal Large Language Models(MLLMs)を使用してユーザーの命令を解釈し、画素精度の高い画像操作を実行します。MLLMsはテキストと画像の両方を処理でき、すでにChatGPTなどのアプリケーションでその能力を示しています。ChatGPTは画像を理解するためにGPT-4Vを使用して画像を理解し、DALL-E 3を使用して新しい画像を生成します。

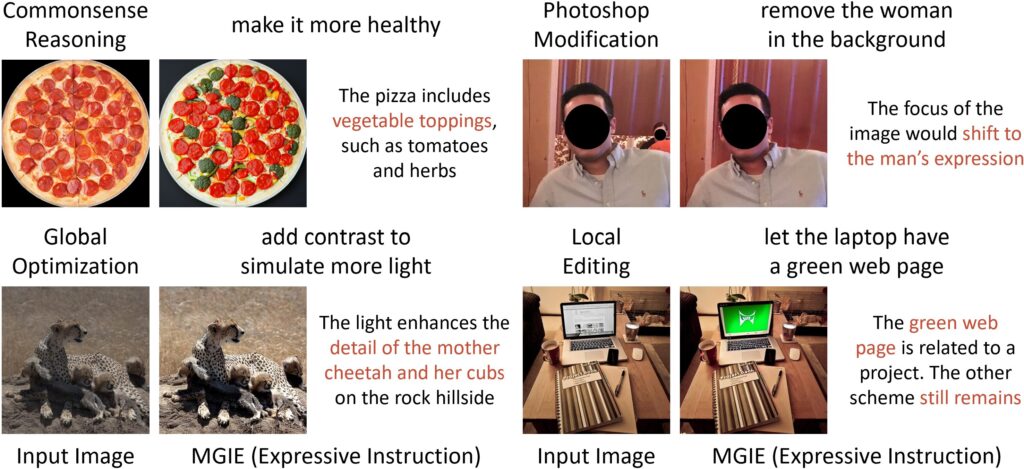

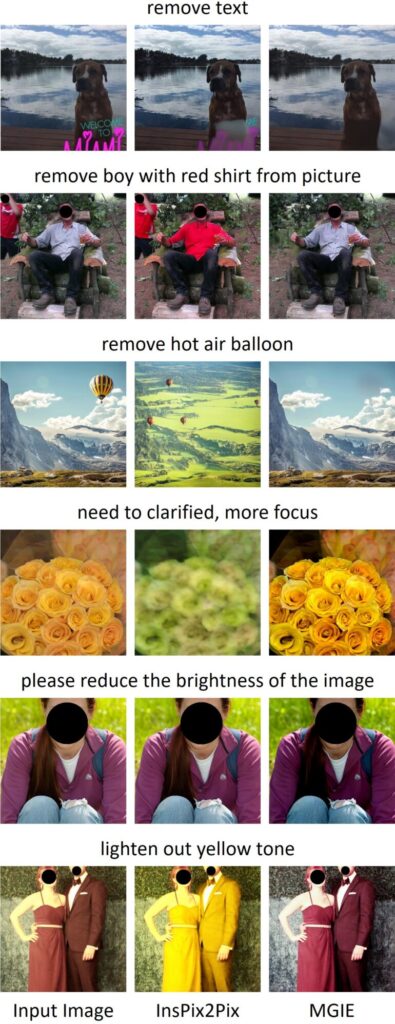

グローバルおよびローカルな操作

MGIEの別の特徴は、グローバルおよびローカルな操作を行う能力です。モデルは、表現豊かな命令に基づいた編集を実行し、トリミング、拡大縮小、回転、ミラーリング、フィルターの追加などの一般的な Photoshop のような編集を適用できます。

また、背景の変更、オブジェクトの追加または削除、複数の画像の結合などの高度な命令も理解し、

Adobe Photoshopのような編集を適用できます。

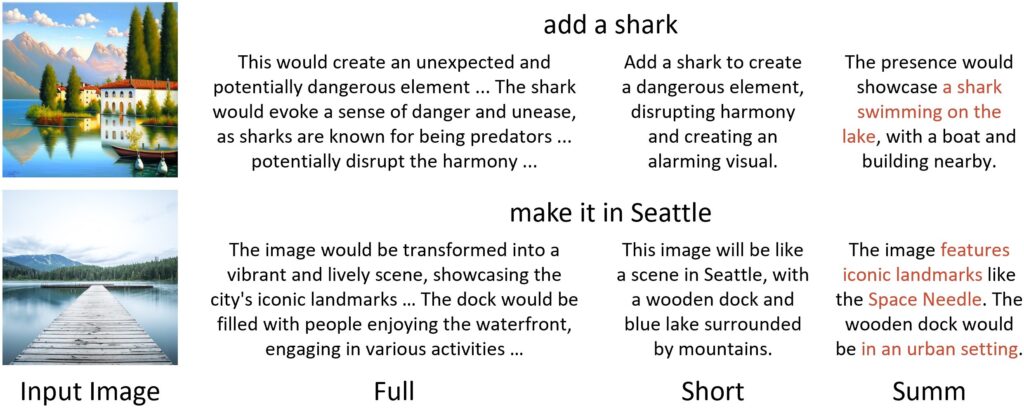

詳細なプロンプトの作成と画像の生成

この手法は2つのステップで構成されています。

まず、1 つ目は、ユーザーの指示が短すぎることが多いという問題を解決することです。

研究者は、非常に詳細なプロンプトを使用して大規模言語モデルを使用して非常に詳細なプロンプトを作成するために

ユーザーの命令に「この画像はどのようになりますか」というプロンプトを付け加えます。

これらは多くの場合、長すぎるため、事前にトレーニングされたモデルを使用して詳細なプロンプトを要約します。

たとえば、「砂漠」という単語は「砂丘」や「サボテン」と関連付けられます。

2番目のステップでは、モデルが画像を生成します。

OpenAIは、ChatGPTでDALL-E 3と同様の手法を使用しています。

MGIEのオープンソースプロジェクト

MGIE は、 GitHubでオープンソース プロジェクトとして入手できます。

Hugging Face のデモもあります。

アップルのAI戦略のもう1つの基盤

MGIEのリリースは、アップルのAI研究開発の成長する野心を示しています。

アップルのCEOであるティム・クックは最近、iOS 18に生成AI機能の導入を確認し、

「この分野でのアップルの取り組みについての信じられないほどの興奮」を表明しました。

上記のような研究は、iOSの新機能に関する

アップルの計画についての一部の洞察を提供するはずです。

InstructPix2Pixとの比較

指示に基づいた画像処理の古いモデルであるInstructPix2Pixもあります。

しかし、この方法はStable Diffusionに基づいており、画像内の個々のオブジェクトを

変更することを意図していますが、MGIEほど精度が高くありません。

まとめ

- アップルとカリフォルニア大学の研究者は、自然言語コマンドを使用して

- 画像を操作できるオープンソースのAIモデルMGIEを開発しました。

- MGIEは、多モード大規模言語モデル(MLLMs)を使用して画素レベルの画像操作を行い

- 一般的なPhotoshopのような操作や背景の変更、複数の画像のマージングなどの高度な操作を実行できます。

- このオープンソースプロジェクトはGitHubで利用可能であり、アップルのAI研究開発の成長する野心を示しています。